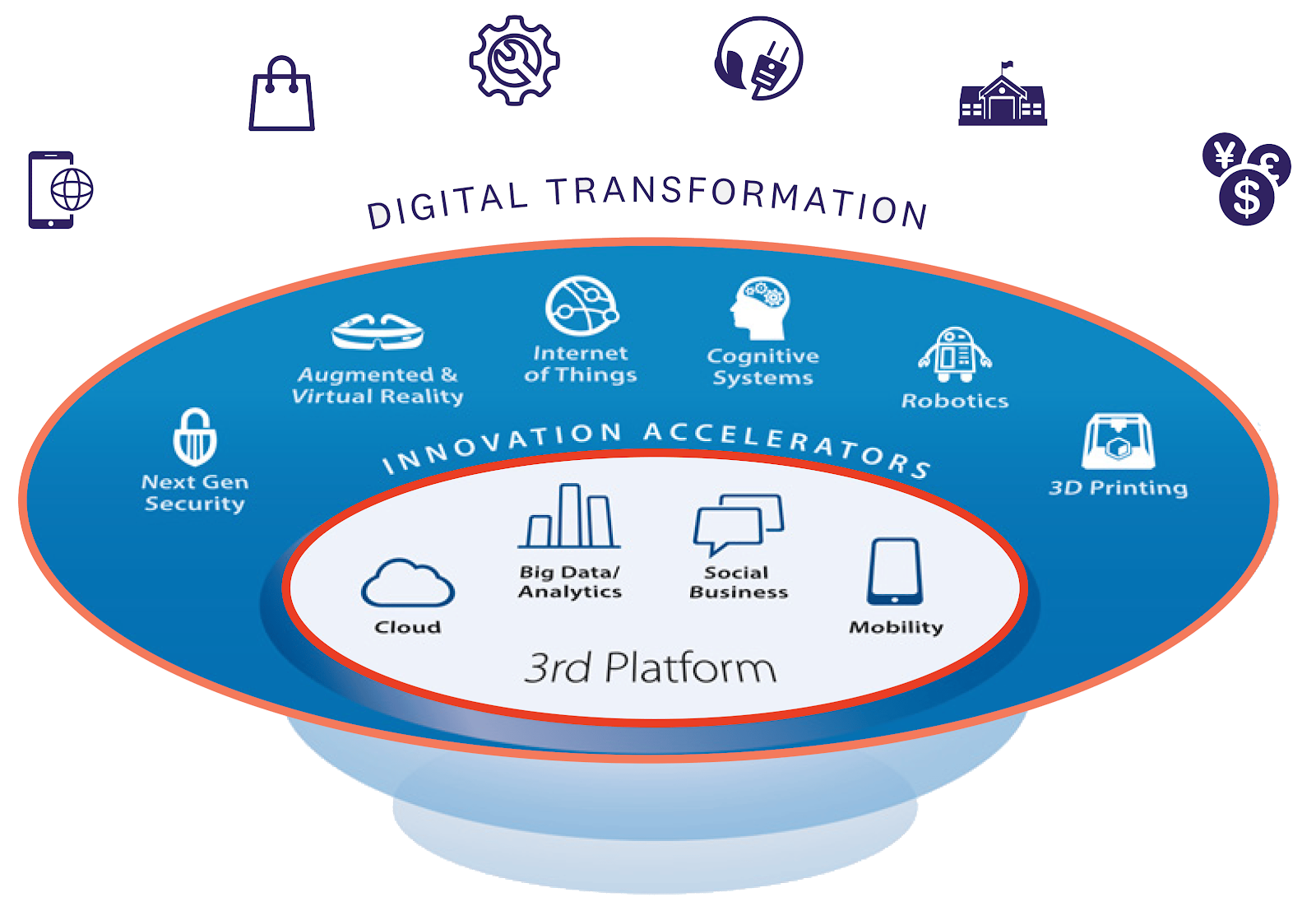

Ya en múltiples ocasiones hemos mencionado y enumerado las doce tecnologías que derivan de la Tranformación Digital, que a su vez algunas de ellas (como el Aprendizaje Automático o Machine Learning) son parte de lo que se conoce como la Cuarta Revolución Industrial.

Es precisamente pues el Aprendizaje de Automático (parte fundamental de la Inteligencia Artificial) de lo que ahora hablaremos en esta entrada.

¿Qué es Aprendizaje Automático?

El Aprendizaje Automático, o Machine Learning en inglés, es una rama de la inteligencia artificial que se centra en el desarrollo de algoritmos y modelos que permiten a las computadoras aprender y mejorar su rendimiento en tareas específicas a partir de la experiencia, en lugar de tener que ser programadas explícitamente para cada situación. En esencia, el Aprendizaje Automático implica construir sistemas que pueden aprender automáticamente a partir de los datos disponibles, identificar patrones y realizar predicciones o tomar decisiones sin intervención humana directa. Este campo tiene una amplia gama de aplicaciones, desde el reconocimiento de voz y de imágenes hasta la detección de fraudes y la conducción autónoma de vehículos.¿Qué personas y/o empresas son considerados los creadores del Aprendizaje Automático?

El campo del Aprendizaje Automático ha sido desarrollado y popularizado por una serie de investigadores, académicos, y empresas a lo largo de varias décadas. Algunas de las personas y empresas más destacadas en este ámbito incluyen:

Personas:

Arthur Samuel: Considerado uno de los pioneros del aprendizaje automático, desarrolló el primer programa de ajedrez de computadora capaz de aprender a jugar mejor a medida que jugaba más partidas.

Frank Rosenblatt: Conocido por su trabajo en perceptrones, una forma temprana de redes neuronales artificiales que sentaron las bases para muchos algoritmos de aprendizaje profundo modernos.

Geoffrey Hinton: Uno de los líderes en el campo del aprendizaje profundo, ha hecho contribuciones significativas a las redes neuronales convolucionales y recurrentes, y ha sido fundamental en el resurgimiento del interés en el aprendizaje profundo en las últimas décadas.

Yoshua Bengio: Otro líder en el campo del aprendizaje profundo, ha realizado importantes contribuciones teóricas y prácticas a la comprensión de los modelos de aprendizaje profundo y su aplicación en una variedad de problemas.

Yann LeCun: Conocido por su trabajo en redes neuronales convolucionales, ha sido fundamental en el desarrollo de técnicas de aprendizaje profundo para el reconocimiento de imágenes y otras tareas de percepción.

Empresas:

Google: Ha sido líder en la investigación y aplicación de técnicas de aprendizaje automático en una amplia gama de productos y servicios, desde el motor de búsqueda hasta la traducción automática y los automóviles autónomos.

Facebook: Utiliza el aprendizaje automático para mejorar la relevancia y la personalización en su plataforma social, así como para abordar problemas como la detección de contenido no deseado y la identificación de noticias falsas.

Amazon: Aplica el aprendizaje automático en áreas como la recomendación de productos, el análisis de datos de clientes y la automatización de procesos empresariales.

Microsoft: Ha invertido en investigación en aprendizaje automático y ha desarrollado herramientas y servicios basados en esta tecnología, como Azure Machine Learning y Cortana Intelligence Suite.

OpenAI: Una organización de investigación sin fines de lucro dedicada al desarrollo seguro y ético de la inteligencia artificial, incluido el aprendizaje automático.

Lo que SÍ es Aprendizaje Automático:

Aprendizaje a partir de datos: El aprendizaje automático implica el uso de algoritmos para aprender patrones y relaciones a partir de conjuntos de datos.

Automatización de tareas: Permite automatizar tareas que de otra manera serían difíciles o impracticables de programar de manera explícita.

Generalización: Los modelos de aprendizaje automático son capaces de generalizar a partir de ejemplos de entrenamiento para hacer predicciones o tomar decisiones sobre nuevos datos.

Mejora con la experiencia: Los modelos de aprendizaje automático mejoran su rendimiento a medida que reciben más datos y retroalimentación.

Adaptabilidad: Los algoritmos de aprendizaje automático pueden adaptarse a cambios en los datos o en el entorno.

Lo que NO es Aprendizaje Automático:

NO es programación tradicional: No se trata simplemente de escribir reglas o algoritmos específicos para realizar una tarea.

NO es una solución para todo: No es una solución universal para todos los problemas; su eficacia depende en gran medida de la calidad de los datos y del diseño adecuado del algoritmo para la tarea específica.

NO es magia: No es una solución mágica que funcione sin una comprensión adecuada del problema y de los datos involucrados.

NO es un reemplazo de la inteligencia humana: Aunque puede automatizar tareas complejas, aún depende de la supervisión humana para su diseño, implementación y evaluación.

¿Cuáles son los alcances y limitaciones del Aprendizaje Automático?

El Aprendizaje Automático tiene una serie de alcances y limitaciones que es importante tener en cuenta:

Alcances:

Automatización de tareas repetitivas: El aprendizaje automático puede automatizar tareas repetitivas y computacionalmente intensivas, liberando tiempo y recursos humanos para actividades más creativas y estratégicas.

Predicción y toma de decisiones: Permite hacer predicciones precisas y tomar decisiones basadas en datos en una amplia gama de aplicaciones, desde el pronóstico del tiempo hasta la detección de fraudes.

Personalización: Facilita la personalización de servicios y productos, como recomendaciones de películas en plataformas de transmisión de video o anuncios dirigidos en línea, basados en el análisis de datos sobre el comportamiento del usuario.

Identificación de patrones: Ayuda a identificar patrones complejos y no lineales en conjuntos de datos grandes y complejos que pueden ser difíciles de detectar para los seres humanos.

Limitaciones:

Dependencia de datos de alta calidad: El rendimiento del aprendizaje automático depende en gran medida de la calidad, la cantidad y la representatividad de los datos utilizados para el entrenamiento. Datos incompletos, sesgados o no representativos pueden llevar a resultados inexactos o sesgados.

Interpretabilidad: Algunos modelos de aprendizaje automático, como las redes neuronales profundas, pueden ser difíciles de interpretar, lo que dificulta la comprensión de cómo y por qué toman ciertas decisiones.

Sobreajuste: Existe el riesgo de que un modelo de aprendizaje automático se ajuste demasiado a los datos de entrenamiento y pierda la capacidad de generalizar a nuevos datos, especialmente si el modelo es muy complejo y el conjunto de datos de entrenamiento es pequeño.

Limitaciones computacionales: Algunos algoritmos de aprendizaje automático, especialmente aquellos que requieren grandes cantidades de datos o cálculos intensivos, pueden ser computacionalmente costosos y requerir hardware especializado para su implementación eficiente.

Ética y sesgo: El aprendizaje automático puede heredar y amplificar sesgos presentes en los datos de entrenamiento, lo que puede llevar a decisiones discriminatorias o injustas si no se abordan adecuadamente.

¿Existe ya algún marco de ética para el Aprendizaje Automático?

Ha habido un creciente reconocimiento de la necesidad de abordar las preocupaciones éticas relacionadas con el desarrollo y la implementación del aprendizaje automático. Aunque no hay un marco único de ética para el Aprendizaje Automático universalmente aceptado, se han propuesto varios principios y directrices por parte de organizaciones, instituciones y expertos en el campo. Aquí hay algunos ejemplos:Principios de Ética en la Inteligencia Artificial de la IEEE: La IEEE (Instituto de Ingenieros Eléctricos y Electrónicos) ha desarrollado una serie de principios éticos que abordan temas como la transparencia, la responsabilidad, la equidad, la seguridad y la privacidad en el diseño y el uso de la inteligencia artificial, incluido el aprendizaje automático.

Directrices de Ética en la Inteligencia Artificial de la Unión Europea: La Unión Europea ha propuesto directrices éticas para el desarrollo y el uso de la inteligencia artificial, que incluyen principios como la equidad, la transparencia, la responsabilidad, la privacidad y la seguridad.

Principios Éticos de Google para la IA: Google ha establecido una serie de principios éticos para guiar el desarrollo y el uso de la inteligencia artificial, que incluyen la equidad, la seguridad, la transparencia, la privacidad y el diseño centrado en el usuario.

Directrices de Ética en el Aprendizaje Automático de la Fundación de Tecnología de la Información y la Innovación de la Fundación Nacional de Ciencias de los Estados Unidos: La Fundación de Tecnología de la Información y la Innovación de la Fundación Nacional de Ciencias de los Estados Unidos ha desarrollado una serie de directrices éticas para el aprendizaje automático que abordan temas como la equidad, la transparencia, la responsabilidad y la justicia algorítmica.

Principios de Ética en el Aprendizaje Automático de la Iniciativa de Ética en el Aprendizaje Automático: La Iniciativa de Ética en el Aprendizaje Automático ha propuesto una serie de principios éticos para guiar el desarrollo y el uso del aprendizaje automático, que incluyen la equidad, la transparencia, la responsabilidad, la inclusión y el impacto social.

¿Quiénes deben de trabajar directa o indirectamente con Aprendizaje Automático?

El aprendizaje automático tiene aplicaciones en una amplia variedad de campos y sectores, por lo que muchas personas pueden beneficiarse de trabajar directa o indirectamente con esta tecnología. Algunas de las personas que podrían involucrarse en el trabajo con aprendizaje automático incluyen:

Científicos de datos: Son responsables de recopilar, limpiar, analizar y modelar datos para desarrollar y aplicar algoritmos de aprendizaje automático en diversas aplicaciones.

Ingenieros de software: Desarrollan e implementan sistemas y aplicaciones que utilizan algoritmos de aprendizaje automático, integrándolos en entornos de producción.

Investigadores en inteligencia artificial: Contribuyen a la investigación y desarrollo de nuevos algoritmos y técnicas de aprendizaje automático para abordar desafíos específicos y avanzar en el campo.

Analistas de negocios: Utilizan herramientas de aprendizaje automático para analizar datos y extraer información valiosa que pueda guiar la toma de decisiones empresariales.

Desarrolladores de productos y servicios: Incorporan capacidades de aprendizaje automático en productos y servicios para mejorar su funcionalidad, personalización y rendimiento.

Profesionales de marketing: Utilizan el aprendizaje automático para analizar datos de clientes y campañas, personalizar la experiencia del usuario y optimizar estrategias de marketing.

Profesionales de la salud: Aplican el aprendizaje automático en el análisis de datos médicos para diagnosticar enfermedades, predecir resultados y personalizar tratamientos.

Ingenieros de robótica: Utilizan el aprendizaje automático para desarrollar sistemas de control y percepción para robots autónomos y sistemas de automatización.

Profesionales de seguridad cibernética: Utilizan técnicas de aprendizaje automático para detectar y prevenir amenazas de seguridad cibernética, como intrusiones y malware.

Diseñadores de experiencia de usuario: Trabajan en la integración de capacidades de aprendizaje automático para mejorar la usabilidad y la personalización de aplicaciones y sitios web.

¿Qué herramientas ya están disponibles para todo lo referente a Aprendizaje Automático?

Hay una amplia gama de herramientas disponibles para trabajar en proyectos de aprendizaje automático, desde bibliotecas de programación hasta plataformas de desarrollo integradas. Aquí hay algunas de las herramientas más populares y ampliamente utilizadas en el campo del aprendizaje automático:

Bibliotecas de aprendizaje automático:

Scikit-learn: Una biblioteca de aprendizaje automático de código abierto para Python que proporciona una amplia gama de algoritmos de aprendizaje supervisado y no supervisado, así como herramientas para preprocesamiento de datos y evaluación de modelos.

TensorFlow: Desarrollado por Google, TensorFlow es una biblioteca de código abierto para aprendizaje automático y aprendizaje profundo que ofrece flexibilidad y escalabilidad para la implementación de modelos complejos en una amplia variedad de dispositivos.

PyTorch: Desarrollado por Facebook, PyTorch es una biblioteca de aprendizaje automático de código abierto que ofrece una interfaz más dinámica y flexible que TensorFlow, lo que lo hace popular entre los investigadores y los desarrolladores experimentales.

Keras: Una biblioteca de aprendizaje profundo de alto nivel que se ejecuta sobre TensorFlow o Theano, que proporciona una interfaz simple y elegante para la creación y entrenamiento de redes neuronales.

MXNet: Una biblioteca de aprendizaje automático de código abierto desarrollada por Apache que ofrece escalabilidad y eficiencia para el entrenamiento de modelos en una variedad de hardware, desde CPU hasta GPU y TPU.

Plataformas de desarrollo integradas:

Herramientas de visualización y análisis de datos:Google Colab: Una plataforma gratuita de Google que permite ejecutar código Python, incluidos los proyectos de aprendizaje automático, en la nube utilizando GPU de forma gratuita, lo que facilita la experimentación y el desarrollo de modelos.

Jupyter Notebook: Una aplicación web de código abierto que permite crear y compartir documentos interactivos que contienen código, visualizaciones y texto explicativo, lo que lo hace ideal para el desarrollo de proyectos de aprendizaje automático de forma colaborativa.

Azure Machine Learning: Una plataforma de Microsoft que ofrece herramientas y servicios para desarrollar, implementar y gestionar modelos de aprendizaje automático en la nube, así como para automatizar y escalar flujos de trabajo de aprendizaje automático.

Amazon SageMaker: Una plataforma de Amazon Web Services (AWS) que facilita la construcción, el entrenamiento y el despliegue de modelos de aprendizaje automático a escala utilizando herramientas y servicios gestionados en la nube.

Matplotlib: Una biblioteca de visualización de datos de Python que proporciona una amplia variedad de gráficos y visualizaciones para explorar y presentar datos.

Seaborn: Basada en Matplotlib, Seaborn ofrece una interfaz de alto nivel para crear visualizaciones estadísticas atractivas y informativas.

Pandas: Una biblioteca de Python que proporciona estructuras de datos y herramientas para manipular y analizar datos de forma rápida y eficiente.

Plotly: Una biblioteca de visualización de datos interactiva que ofrece una amplia gama de gráficos interactivos y dashboards.

Estas son solo algunas de las muchas herramientas disponibles para trabajar en proyectos de aprendizaje automático. La elección de la herramienta adecuada dependerá de los requisitos específicos del proyecto, la preferencia personal y la familiaridad con las tecnologías involucradas.

¿Qué empresas u organizaciones ya están aplicando Aprendizaje Automático en el día a día?

Muchas empresas y organizaciones están aplicando activamente el Aprendizaje Automático en diversas áreas de su operación para mejorar la eficiencia, la precisión y la personalización. Aquí tienes algunos ejemplos de empresas y organizaciones que utilizan el aprendizaje automático en su día a día:Google: Utiliza el aprendizaje automático en una amplia gama de productos y servicios, como el motor de búsqueda, el traductor de idiomas, Google Maps, Gmail y el asistente virtual Google Assistant, para mejorar la precisión de los resultados, la relevancia de las recomendaciones y la personalización de la experiencia del usuario.

Facebook: Aplica el aprendizaje automático para personalizar el feed de noticias, recomendar amigos y contenido, detectar y eliminar contenido no deseado como spam y noticias falsas, y mejorar la precisión de la orientación de anuncios.

Amazon: Utiliza el aprendizaje automático en áreas como la recomendación de productos, la optimización de precios, la gestión de inventario, la detección de fraudes y la automatización de almacenes con robots autónomos.

Netflix: Aplica el aprendizaje automático para personalizar las recomendaciones de películas y programas de televisión, optimizar el contenido visual y mejorar la eficiencia operativa en áreas como la entrega de contenido y la detección de piratería.

Uber: Utiliza el aprendizaje automático para predecir la demanda de viajes, calcular rutas óptimas, mejorar la precisión de las estimaciones de tiempo de llegada y detectar y prevenir fraudes.

Airbnb: Aplica el aprendizaje automático para personalizar las recomendaciones de alojamiento, predecir los precios de las propiedades, mejorar la precisión de las búsquedas y la detección de fraudes.

Tesla: Utiliza el aprendizaje automático en sus vehículos autónomos para procesar datos de sensores y cámaras en tiempo real, reconocer objetos y señales de tráfico, y tomar decisiones de conducción autónoma.

Microsoft: Aplica el aprendizaje automático en productos y servicios como Bing, Office 365, Xbox, Skype y Azure para mejorar la búsqueda, la productividad, la seguridad y la personalización.

IBM: Utiliza el aprendizaje automático en áreas como la inteligencia artificial en la atención médica, el análisis de datos en la nube, la seguridad cibernética y la optimización empresarial.

"X" antes Twitter: Aplica el aprendizaje automático para mejorar la relevancia de los tweets, detectar y filtrar contenido no deseado como spam y bots, y ofrecer recomendaciones personalizadas de cuentas y contenido.

¿Cómo y para qué se están utilizando las Graphic Processor Units en aplicaciones de Aprendizaje Automático?

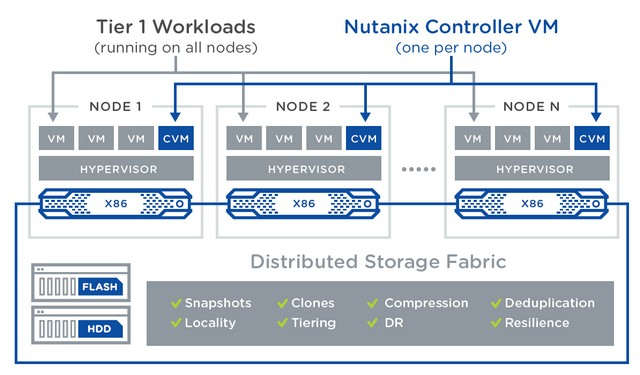

Las Unidades de Procesamiento Gráfico (GPU) se han vuelto fundamentales en aplicaciones de aprendizaje automático debido a su capacidad para realizar cálculos paralelos de manera eficiente. Aquí te explico cómo y para qué se están utilizando las GPUs en aplicaciones de Machine Learning:Aprovechamiento del paralelismo: Las GPUs están diseñadas para procesar múltiples tareas simultáneamente, lo que las hace ideales para acelerar operaciones matemáticas intensivas, como las que se encuentran en los algoritmos de aprendizaje automático.

Entrenamiento de modelos: En el entrenamiento de modelos de aprendizaje automático, especialmente en redes neuronales profundas, se realizan muchas operaciones matriciales y de tensor que pueden realizarse de manera eficiente en paralelo utilizando GPUs. Esto permite acelerar significativamente el tiempo de entrenamiento de los modelos.

Inferencia en tiempo real: En la inferencia, que es la etapa en la que se utilizan los modelos entrenados para hacer predicciones o tomar decisiones en tiempo real, las GPUs pueden acelerar el procesamiento de grandes volúmenes de datos, lo que permite aplicaciones como el reconocimiento de voz, la traducción automática y la detección de objetos en imágenes en tiempo real.

Procesamiento de grandes conjuntos de datos: Las GPUs pueden procesar grandes conjuntos de datos de manera eficiente, lo que permite trabajar con conjuntos de datos de alta dimensionalidad y gran tamaño, como imágenes de alta resolución o datos de secuenciación genómica.

Investigación y experimentación: Las GPUs permiten a los investigadores y científicos de datos experimentar con modelos de aprendizaje automático más grandes y complejos, así como con técnicas avanzadas como el aprendizaje profundo, acelerando el proceso de iteración y descubrimiento.

¿Qué marcas y modelos de Graphic Processor Units son actualmente las más utilizadas para Aprendizaje Automático?

En el ámbito del aprendizaje automático, algunas marcas y modelos de Unidades de Procesamiento Gráfico (GPU) son especialmente populares debido a su rendimiento, capacidad de cálculo y compatibilidad con marcos de aprendizaje automático populares como TensorFlow y PyTorch. Aquí hay algunas de las GPUs más utilizadas para Machine Learning en la actualidad:

NVIDIA GeForce RTX y RTX 30 Series: Las tarjetas gráficas de la serie GeForce RTX, incluidas las últimas RTX 30 Series como la RTX 3080 y la RTX 3090, son muy populares en el ámbito del aprendizaje automático debido a su alto rendimiento y soporte para tecnologías como CUDA y Tensor Cores, que aceleran significativamente el entrenamiento de modelos de aprendizaje profundo.

NVIDIA Quadro y Quadro RTX: Las tarjetas gráficas profesionales de la serie Quadro, incluidas las últimas Quadro RTX, son utilizadas en entornos empresariales y de investigación donde se requiere una precisión y fiabilidad excepcionales, así como características como la compatibilidad con múltiples GPU y la certificación de aplicaciones.

NVIDIA Tesla: Las tarjetas gráficas Tesla, especialmente la serie Tesla V100, son muy utilizadas en centros de datos y supercomputadoras para aplicaciones de aprendizaje automático a gran escala debido a su gran cantidad de memoria, ancho de banda de memoria y rendimiento de cálculo.

AMD Radeon Instinct: Las tarjetas gráficas profesionales de AMD, como la Radeon Instinct MI100, están ganando popularidad en el ámbito del aprendizaje automático debido a su rendimiento competitivo y su enfoque en la eficiencia energética.

Google TPU (Tensor Processing Unit): Aunque no es una GPU tradicional, el TPU de Google es una unidad de procesamiento diseñada específicamente para acelerar el entrenamiento e inferencia de modelos de aprendizaje automático en la infraestructura de Google Cloud, ofreciendo un rendimiento excepcional para aplicaciones de TensorFlow.

¿Qué libros y documentación hay disponible para el Aprendizaje Automático?

Hay una gran cantidad de libros y recursos disponibles para aprender sobre aprendizaje automático, desde introducciones básicas hasta textos avanzados que cubren temas especializados. Aquí hay una lista de algunos libros populares y ampliamente recomendados en el campo del aprendizaje automático:"Introducción al Aprendizaje Automático" ("Introduction to Machine Learning") de Ethem Alpaydin: Este libro proporciona una introducción accesible al aprendizaje automático, cubriendo una amplia gama de técnicas y aplicaciones.

"Aprendizaje Automático: Un Enfoque Probabilístico" ("Machine Learning: A Probabilistic Perspective") de Kevin P. Murphy: Este libro aborda el aprendizaje automático desde una perspectiva probabilística, cubriendo tanto los fundamentos teóricos como las aplicaciones prácticas.

"Patrones de Aprendizaje Automático" ("Pattern Recognition and Machine Learning") de Christopher M. Bishop: Este libro es una referencia ampliamente utilizada en el campo del aprendizaje automático, que cubre temas como clasificación, regresión, agrupamiento y técnicas de reducción de la dimensionalidad.

"Aprendizaje Profundo" ("Deep Learning") de Ian Goodfellow, Yoshua Bengio y Aaron Courville: Este libro es una introducción exhaustiva al aprendizaje profundo, cubriendo tanto los fundamentos teóricos como las aplicaciones prácticas en áreas como la visión por computadora, el procesamiento del lenguaje natural y la robótica.

"Aprendizaje Automático en Acción" ("Machine Learning in Action") de Peter Harrington: Este libro ofrece una introducción práctica al aprendizaje automático con ejemplos de código en Python, cubriendo técnicas como la regresión, el agrupamiento y el aprendizaje no supervisado.

"Python para el Aprendizaje Automático" ("Python Machine Learning") de Sebastian Raschka y Vahid Mirjalili: Este libro se centra en el uso de Python para aplicaciones de aprendizaje automático, cubriendo técnicas como clasificación, regresión, agrupamiento y aprendizaje profundo.

"El Aprendizaje Automático de Por Vida" ("Lifelong Machine Learning") de Zhiyuan Chen, Bing Liu y Philip S. Yu: Este libro aborda el aprendizaje automático desde una perspectiva de aprendizaje de por vida, explorando cómo los sistemas de aprendizaje automático pueden adaptarse y mejorar con el tiempo.

Además de estos libros, hay una gran cantidad de recursos en línea, cursos en línea, tutoriales y documentación disponible para aprender sobre aprendizaje automático. Plataformas como Coursera, Udacity, edX y Khan Academy ofrecen una amplia variedad de cursos y materiales educativos en el campo del aprendizaje automático.

¿Qué temas y elementos didácticos son indispensables para un curso de Aprendizaje Automático?

Un curso de aprendizaje automático exitoso debe cubrir una variedad de temas y elementos didácticos para proporcionar a los estudiantes una comprensión completa de los fundamentos teóricos y las aplicaciones prácticas de esta disciplina. Aquí hay algunos temas y elementos indispensables que podrían incluirse en un curso de aprendizaje automático:

Introducción al aprendizaje automático:

- Definición y conceptos básicos.

- Aplicaciones y casos de uso en la vida real.

- Breve historia y evolución del aprendizaje automático.

Fundamentos matemáticos:

- Álgebra lineal.

- Cálculo.

- Probabilidad y estadística.

Aprendizaje supervisado:

- Regresión.

- Clasificación.

- Métricas de evaluación de modelos.

Aprendizaje no supervisado:

- Agrupamiento.

- Reducción de la dimensionalidad.

- Análisis de componentes principales (PCA).

Aprendizaje profundo:

- Redes neuronales artificiales.

- Arquitecturas de redes neuronales (CNN, RNN, LSTM).

- Entrenamiento y optimización de redes neuronales.

Técnicas de preprocesamiento de datos:

- Limpieza de datos.

- Normalización y escalado de características.

- Manejo de datos faltantes y desbalanceados.

Validación y selección de modelos:

- Validación cruzada.

- Selección de hiperparámetros.

- Sintonización del modelo.

Ética y responsabilidad en el aprendizaje automático:

- Sesgo y equidad algorítmica.

- Privacidad y seguridad de datos.

- Impacto social y ético del aprendizaje automático.

Herramientas y bibliotecas de aprendizaje automático:

- Python y sus bibliotecas (NumPy, Pandas, Scikit-learn, TensorFlow, PyTorch, etc.).

- Entornos de desarrollo y colaboración (Jupyter Notebook, Google Colab).

Aplicaciones prácticas y proyectos:

- Desarrollo de proyectos de aprendizaje automático desde cero.

- Trabajo con conjuntos de datos reales.

- Implementación y evaluación de modelos en diferentes dominios.

Recursos adicionales:

- Lecturas adicionales, papers y libros relevantes.

- Enlaces a cursos en línea, tutoriales y documentación.

Además de estos temas, es importante que el curso incluya ejercicios prácticos, estudios de casos, proyectos prácticos y sesiones de discusión para que los estudiantes puedan aplicar los conceptos aprendidos y desarrollar habilidades prácticas en el aprendizaje automático. La combinación de teoría y práctica es fundamental para una comprensión sólida y una aplicación efectiva de los principios del aprendizaje automático.

¿Qué Universidades e Institutos Tecnológicos de América Latina ofrecen ya estudios referentes al Aprendizaje Automático?

En América Latina, varias instituciones educativas ofrecen programas de estudio relacionados con el aprendizaje automático, ya sea como parte de programas de grado, posgrado o cursos especializados. Aquí hay algunas instituciones destacadas en la región que ofrecen estudios en este campo:Instituto Tecnológico de Buenos Aires (ITBA) - Argentina: Ofrece programas de grado y posgrado en ingeniería informática y sistemas, que incluyen cursos y especializaciones en aprendizaje automático y ciencia de datos.

Universidad de Buenos Aires (UBA) - Argentina: La Facultad de Ciencias Exactas y Naturales ofrece cursos y programas de posgrado en áreas relacionadas con la informática y la ciencia de datos, que incluyen aprendizaje automático y minería de datos.

Universidad de São Paulo (USP) - Brasil: La Escuela Politécnica de la USP ofrece programas de grado y posgrado en ingeniería de computación y ciencia de datos, que incluyen cursos y especializaciones en aprendizaje automático.

Universidad de Campinas (UNICAMP) - Brasil: Ofrece programas de grado y posgrado en ciencia de la computación y áreas afines, con cursos y proyectos de investigación en aprendizaje automático y minería de datos.

Universidad de los Andes - Colombia: La Facultad de Ingeniería de la Universidad de los Andes ofrece programas de pregrado y posgrado en ingeniería de sistemas y ciencia de datos, con énfasis en aprendizaje automático y análisis de datos.

Universidad de Chile - Chile: Ofrece programas de pregrado y posgrado en informática y ciencia de datos, con cursos y especializaciones en aprendizaje automático y análisis de datos.

Universidad Nacional Autónoma de México (UNAM) - México: La Facultad de Ciencias y la Facultad de Ingeniería ofrecen programas de licenciatura y posgrado en informática y ciencias de la computación, con cursos y líneas de investigación en aprendizaje automático.

Instituto Tecnológico y de Estudios Superiores de Monterrey (ITESM) - México: Ofrece programas de licenciatura y posgrado en áreas relacionadas con la informática y la ciencia de datos, con cursos y especializaciones en aprendizaje automático y análisis de datos.

La oferta educativa en este campo está en constante crecimiento y evolución, por lo que es posible que haya otras instituciones que también ofrezcan programas relevantes en la región.

Conclusión:

El Aprendizaje Automático es una poderosa herramienta para automatizar tareas y hacer predicciones a partir de datos, pero no es una solución milagrosa y requiere un enfoque cuidadoso y una comprensión sólida de los problemas y los datos involucrados.

El Aprendizaje Automático es una herramienta poderosa con una amplia gama de aplicaciones, pero es importante ser consciente de sus limitaciones y desafíos, y aplicarlo de manera ética y responsable.

El Aprendizaje Automático es una tecnología versátil que puede beneficiar a una amplia gama de profesionales en diversos campos, desde la ciencia de datos y la ingeniería de software hasta la atención médica y el marketing. Aquellos con habilidades en análisis de datos, programación y comprensión de dominios específicos pueden encontrar oportunidades emocionantes para trabajar con aprendizaje automático.

Las GPUs son una herramienta poderosa para acelerar el entrenamiento y la inferencia de modelos de aprendizaje automático, permitiendo aplicaciones más rápidas, eficientes y escalables en una variedad de campos, desde la visión por computadora hasta el procesamiento del lenguaje natural y la bioinformática.

¿Listo para el Aprendizaje Automático?